LLaMA2安装

LLaMA2安装

LLaMA2是meta开源的大预言模型,基于transformer架构实现。

本文介绍如何利用可视化工具text-generation-webui来装载llama2-7b-chat-hf模型,并进行推理测试

text-generation-webui

text-generation-webui是一个基于gradio开源的web用户界面工具,旨在为大预言模型提供一个简单易用的交互平台

本地安装步骤

1 | step1 拉取github仓库 |

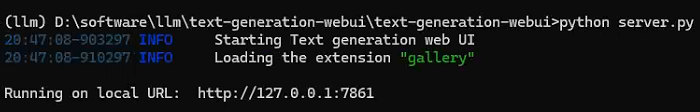

成功启动的运行结果为:

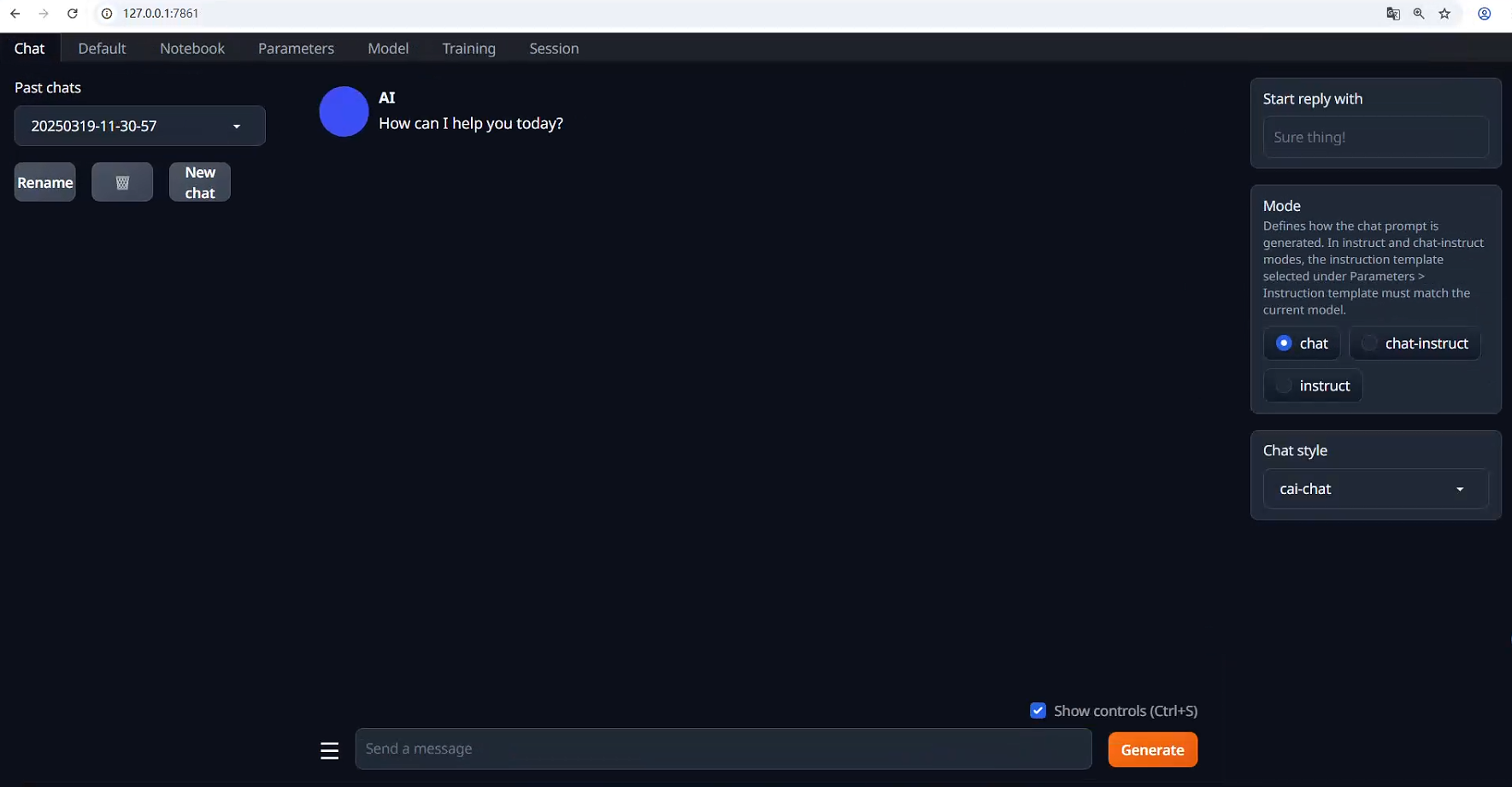

浏览器访问http://127.0.0.1:7861,界面为:

安装模型llama2-7b-chat-hf

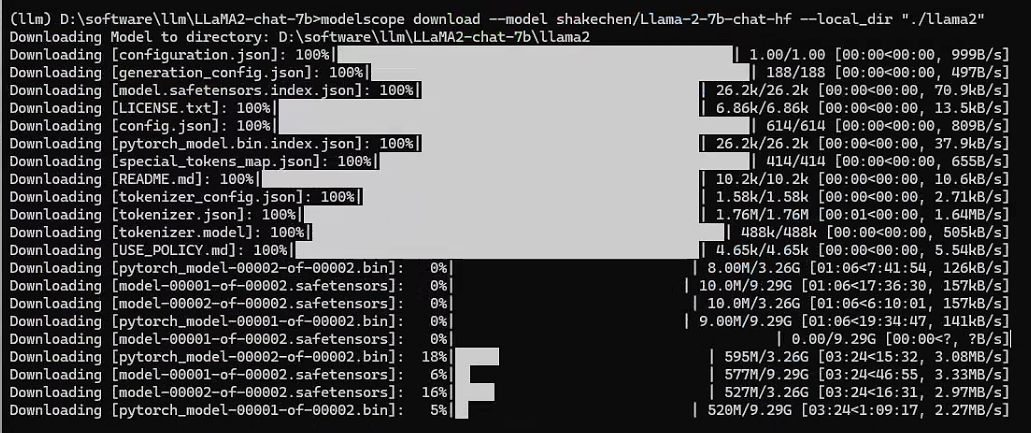

1 | modelcope download --model shakechen/Llama-2-7b-chat-hf --local_dir "./llama2" |

装载模型&模型推理

从Github上拉取的代码里面有一个models文件夹,将从hugging face或者modelscope上下载下来的模型文件复制到该目录下

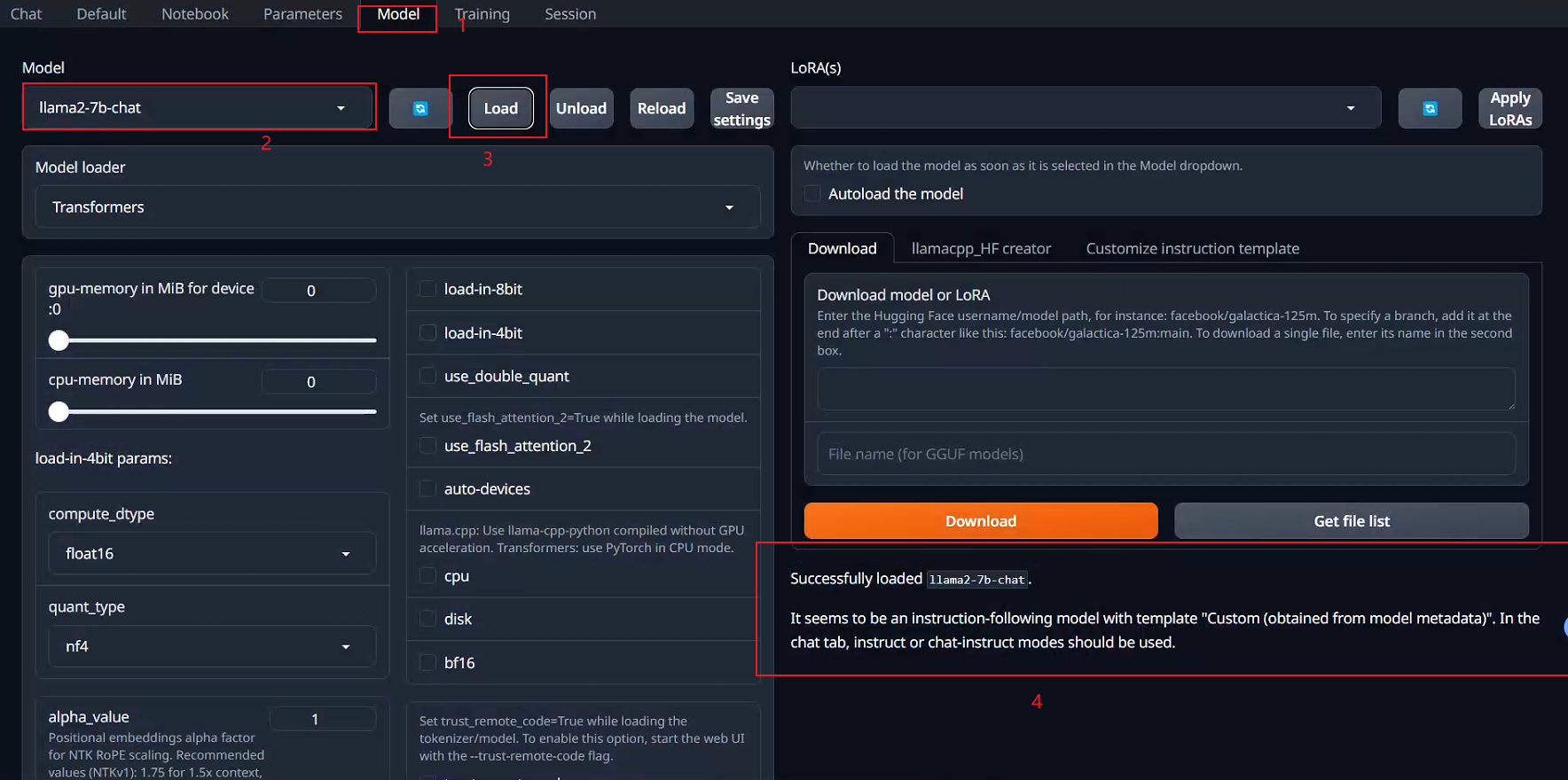

然后从web页面选择模型进行加载

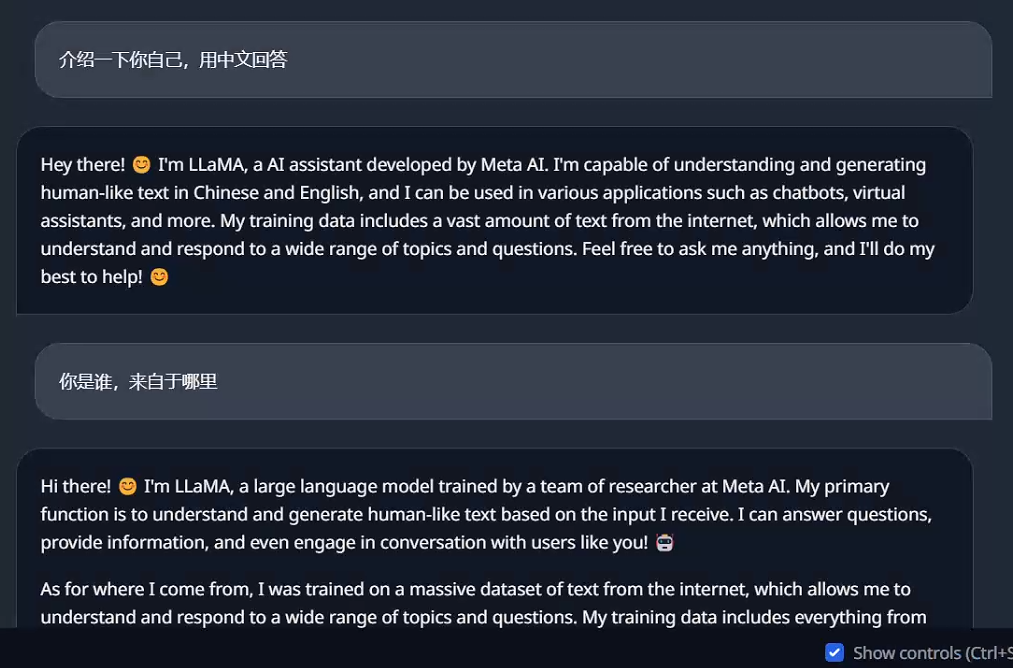

然后点击chat选项卡,注意chat页面的Mode选择instruct,结果可以看出,llama2可以理解中文问题,但是回答都是英文的,效果一般,这是因为LLaMA2的训练语料中仅有0.13%的中文语料

利用text-generation-webui装载chatGLM3进行测试,步骤与上述相同,下载模型文件、复制到models目录、从页面选择模型进行装载、测试

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 Bang's Blog!